昨晚11点,我还在手动整理上周收到的几十封会议纪要和项目文档,感觉眼睛都要花了。那一刻我就在想,要是能有个“数字影子”,替我处理这些机械的琐事该多好。

今天,这个想法成真了。我成功在本地部署了一个名为 OpenClaw 的AI智能体,并让它接入了我最常用的飞书和腾讯混元大模型。现在,我只需要在飞书上发一句:“把昨天所有带‘预算’关键词的邮件摘要发我”,几分钟后,一份清晰的列表就会出现在聊天窗口。

这听起来有点科幻,但实现过程,更像是一次有趣的技术乐高搭建。如果你也受够了日复一日的重复劳动,想拥有一个专属的AI助手,不妨跟着我的足迹试试看。

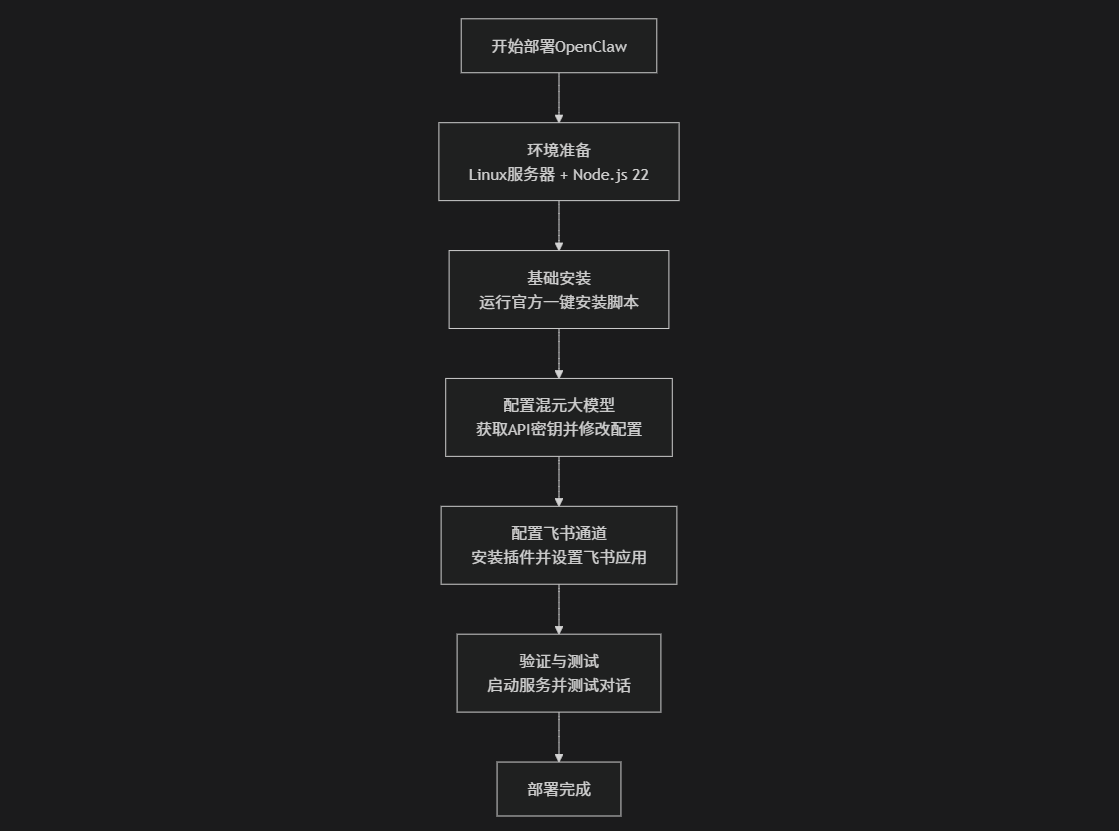

📦 第一步:基础环境部署

完成OpenClaw的基本安装是后续所有配置的基础。

-

准备环境:需要一台Linux服务器(本地电脑或云服务器均可),并确保安装了 Node.js 22或更高版本。

# 下载并安装 nvm: curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.40.3/install.sh | bash # 代替重启 shell\. "$HOME/.nvm/nvm.sh" # 下载并安装 Node.js: nvm install 22 # 验证 Node.js 版本: node -v # Should print "v22.22.0". # 验证 npm 版本: npm -v # Should print "10.9.4".

-

执行安装:在终端中运行以下官方一键安装脚本:

curl -fsSL https://openclaw.ai/install.sh | bash

-

注意:如果安装时出现

npm install failed错误,通常是服务器内存不足(建议2G以上),可以尝试配置Swap交换空间来解决。

-

-

完成初始化:安装脚本运行后,会进入交互式引导(Onboarding)。按照提示选择或参考以下建议:

-

I understand this is powerful and inherently risky. Continue?选择Yes。 -

Onboarding mode选择QuickStart。 -

遇到选择模型服务商(Model/auth provider)和渠道(Select channel)时,都可以先选择

Skip for now,我们稍后再手动配置。

-

🧠 第二步:配置腾讯混元大模型

安装完成后,需要为OpenClaw配置AI大脑。腾讯混元提供了兼容OpenAI的API接口。

-

获取API密钥:

-

登录腾讯云大模型API控制台。

-

在“系统设置”中开通混元大模型服务及后付费。

-

在“接入管理”页面,点击“创建 API-KEY”并保存好生成的密钥。

-

-

修改OpenClaw配置:

将下面命令中的你的混元API密钥替换为实际值后执行,以添加模型提供商。openclaw config set 'models.providers.hunyuan' --json '{ "baseUrl": "https://api.hunyuan.cloud.tencent.com/v1", "apiKey": "你的混元API密钥", "api": "openai-completions", "models": [ { "id": "hunyuan-turbos-latest", "name": "hunyuan Turbos" }, { "id": "hunyuan-t1-latest", "name": "hunyuan T1" } ] }'

-

设置默认模型并重启:

openclaw config set models.mode merge openclaw models set hunyuan/hunyuan-turbos-latest openclaw gateway restart

🤖 第三步:接入飞书机器人

这是为了让AI助手能在飞书上与你对话。

-

安装飞书插件:

openclaw plugins install @m1heng-clawd/feishu -

创建并配置飞书应用:

-

登录飞书开放平台,创建企业自建应用,并添加“机器人”能力。

-

在应用的“凭证与基础信息”页面,获取并保存

App ID和App Secret。

-

-

配置OpenClaw飞书通道:

将下面命令中的你的App ID和你的App Secret替换后执行。openclaw config set channels.feishu.appId "你的App ID" openclaw config set channels.feishu.appSecret "你的App Secret" openclaw config set channels.feishu.enabled true # 推荐使用长连接模式,更稳定 openclaw config set channels.feishu.connectionMode websocket

-

配置飞书应用事件与权限:

-

在飞书开发者后台,进入应用“事件与回调”页面,订阅方式选择

长连接模式,并添加“接收消息”事件。 -

在“权限管理”页面,开通至少以下核心权限:

-

contact:user.base:readonly -

im:message(以及相关的发送、接收子权限)

-

-

-

发布应用:在飞书后台创建并发布一个应用版本。发布后,重启OpenClaw网关使配置生效:

openclaw gateway restart

✅ 第四步:验证与测试

-

检查服务:运行

openclaw status或openclaw gateway status,确认所有服务运行正常。 -

测试对话:

-

在飞书中:在飞书里找到你发布的应用,发送消息进行测试。

-

在Web界面:运行

openclaw dashboard命令,复制生成的URL到浏览器打开,可以在Web界面直接与AI助手对话,验证混元模型是否正常工作。

-

💎 配置要点与提醒

-

安全性提醒:OpenClaw拥有系统级高权限,强烈建议在独立的、不包含敏感数据的服务器或虚拟机中部署,不要直接安装在个人主力工作机上。

-

命令兼容性:该项目曾更名(Clawdbot → Moltbot → OpenClaw)。如果遇到

openclaw命令找不到的情况,可以尝试使用旧命令clawdbot或moltbot,它们功能相同。 -

网络与费用:确保服务器能稳定访问公网。使用腾讯混元等云端大模型API会产生费用,请注意监控使用量。

如果在对接飞书时遇到机器人不回复消息的问题,可以按以下顺序排查:

-

检查飞书插件是否安装成功:

openclaw plugins list -

确认

App ID和App Secret是否配置正确,且已重启网关。 -

登录飞书开放平台,确认“接收消息”事件是否已添加,应用权限是否已开通,并且应用版本已经发布。

如今,这个助手已经安静地运行在我的服务器上。它不会主动打扰我,但随时等待我的召唤,去处理那些曾消耗我无数时间的“数字杂务”。

✅云端秒级部署(推荐)

玩转Lighthouse,云端一键秒级部署OpenClaw:https://curl.qcloud.com/52zSMIJx

我们也可以使用阿里云的轻量级服务器安装:https://www.aliyun.com/activity/ecs/clawdbot